Hadoop文件系统是使用分布式文件系统设计开发的.它在商品硬件上运行.与其他分布式系统不同,HDFS具有高度容错能力,使用低成本硬件进行设计.

HDFS可以容纳大量数据并提供更方便的访问.为了存储如此庞大的数据,文件存储在多台机器上.这些文件以冗余方式存储,以便在发生故障时使系统免于可能的数据丢失. HDFS还使应用程序可用于并行处理.

适用于分布式存储和处理.

Hadoop提供了一个与HDFS交互的命令接口.

namenode和datanode的内置服务器可以帮助用户轻松检查集群的状态.

流式访问文件系统数据.

HDFS提供文件权限和身份验证.

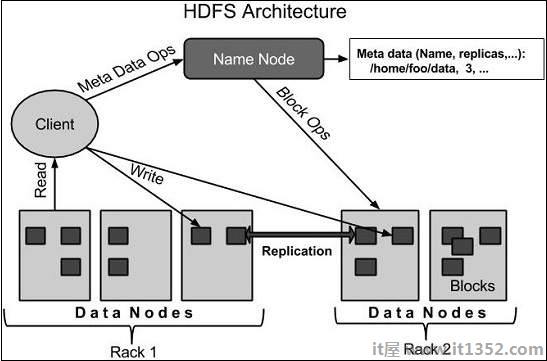

下面给出了Hadoop文件系统的架构.

HDFS遵循主从架构,它具有以下元素.

namenode是包含GNU/Linux操作系统和namenode软件的商品硬件.它是一种可以在商用硬件上运行的软件.具有namenode的系统充当主服务器,它执行以下任务 :

管理文件系统命名空间.

规范客户对文件的访问权.

它还执行文件系统操作,例如重命名,关闭和打开文件和目录.

datanode是商品具有GNU/Linux操作系统和datanode软件的硬件.对于群集中的每个节点(商品硬件/系统),都会有一个datanode.这些节点管理其系统的数据存储.

Datanodes根据客户端对文件系统执行读写操作请求.

他们还会根据namenode的说明执行块创建,删除和复制等操作.

通常用户数据存储在HDFS的文件中.文件系统中的文件将被分成一个或多个段和/或存储在各个数据节点中.这些文件段称为块.换句话说,HDFS可以读取或写入的最小数据量称为块.默认块大小为64MB,但可以根据需要更改HDFS配置来增加.

故障检测和恢复 : 由于HDFS包含大量商品硬件,因此组件故障频繁.因此,HDFS应该具有快速和自动故障检测和恢复的机制.

巨大的数据集 : HDFS每个群集应该有数百个节点来管理具有大量数据集的应用程序.

数据硬件 : 当计算发生在数据附近时,可以有效地完成所请求的任务.特别是在涉及大量数据集的情况下,它可以减少网络流量并提高吞吐量.