所有Hadoop子项目,如Hive,Pig和HBase都支持Linux操作系统.因此,您需要在系统上安装Linux flavor. HCatalog于2013年3月26日与Hive Installation合并.从Hive-0.11.0版开始,HCatalog随附Hive安装.因此,请按照下面给出的步骤安装Hive,Hive会自动在您的系统上安装HCatalog.

Java必须在安装Hive之前在系统上安装.您可以使用以下命令检查系统上是否已安装Java并减去;

$ java -version

如果您的系统上已经安装了Java,您将看到以下响应 :

java version "1.7.0_71" Java(TM) SE Runtime Environment (build 1.7.0_71-b13) Java HotSpot(TM) Client VM (build 25.0-b02, mixed mode)

如果您的系统上没有安装Java,则需要按照以下步骤进行操作.

通过访问以下链接下载Java(JDK<最新版本> - X64.tar.gz) http://www.oracle.com/

然后 jdk-7u71- linux-x64.tar.gz 将被下载到你的系统上.

一般来说你会发现下载的Java f ile在Downloads文件夹中.使用以下命令验证并解压缩 jdk-7u71-linux-x64.gz 文件.

$ cd Downloads/ $ ls jdk-7u71-linux-x64.gz $ tar zxf jdk-7u71-linux-x64.gz $ ls jdk1.7.0_71 jdk-7u71-linux-x64.gz

要使所有用户都能使用Java,您必须将其移至"在/usr/本地/".打开root,然后输入以下命令.

$ su password: # mv jdk1.7.0_71 /usr/local/ # exit

要设置 PATH 和 JAVA_HOME 变量,请添加以下命令到〜/.bashrc 文件.

export JAVA_HOME=/usr/local/jdk1.7.0_71 export PATH=PATH:$JAVA_HOME/bin

现在使用命令 java -version 验证安装终端如上所述.

在安装Hive之前,必须在系统上安装Hadoop.让我们使用以下命令验证Hadoop安装 :

$ hadoop version

如果您的系统上已经安装了Hadoop,那么您将获得以下响应 :

Hadoop 2.4.1 Subversion https://svn.apache.org/repos/asf/hadoop/common -r 1529768 Compiled by hortonmu on 2013-10-07T06:28Z Compiled with protoc 2.5.0 From source with checksum 79e53ce7994d1628b240f09af91e1af4

如果您的系统上未安装Hadoop,请继续执行以下步骤 :

使用以下命令从Apache Software Foundation下载并解压缩Hadoop 2.4.1.

$ su password: # cd /usr/local # wget http://apache.claz.org/hadoop/common/hadoop-2.4.1/ hadoop-2.4.1.tar.gz # tar xzf hadoop-2.4.1.tar.gz # mv hadoop-2.4.1/* to hadoop/ # exit

以下步骤用于以伪分布式模式安装 Hadoop 2.4.1 .

您可以通过将以下命令附加到〜/.bashrc 文件来设置Hadoop环境变量.

export HADOOP_HOME=/usr/local/hadoop export HADOOP_MAPRED_HOME=$HADOOP_HOME export HADOOP_COMMON_HOME=$HADOOP_HOME export HADOOP_HDFS_HOME=$HADOOP_HOME export YARN_HOME=$HADOOP_HOME export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native export PATH=$PATH:$HADOOP_HOME/sbin:$HADOOP_HOME/bin

现在将所有更改应用到当前运行的系统中.

$ source ~/.bashrc

您可以在t中找到所有Hadoop配置文件他的位置"$ HADOOP_HOME/etc/hadoop".您需要根据您的Hadoop基础架构对这些配置文件进行适当的更改.

$ cd $ HADOOP_HOME/etc/hadoop

为了使用Java开发Hadoop程序,您必须通过替换 JAVA_HOME来重置 hadoop-env.sh 文件中的Java环境变量系统中Java的位置值.

export JAVA_HOME =/usr/local/jdk1.7.0_71

以下是您必须编辑以配置Hadoop的文件列表.

core-site.xml 文件包含诸如用于Hadoop实例的端口号,为文件系统分配的内存,用于存储数据的内存限制以及读/写缓冲区的大小.

打开core-site.xml并在< configuration>之间添加以下属性.和</configuration>标签.

<configuration> <property> <name>fs.default.name</name> <value>hdfs://localhost:9000</value> </property> </configuration>

hdfs-site.xml 文件包含的信息例如复制数据的值,namenode路径和本地文件系统的datanode路径.它表示您希望存储Hadoop基础结构的位置.

让我们假设以下数据.

dfs.replication (data replication value) = 1 (In the following path /hadoop/ is the user name. hadoopinfra/hdfs/namenode is the directory created by hdfs file system.) namenode path = //home/hadoop/hadoopinfra/hdfs/namenode (hadoopinfra/hdfs/datanode is the directory created by hdfs file system.) datanode path = //home/hadoop/hadoopinfra/hdfs/datanode

打开此文件并在< configuration>之间添加以下属性, </结构>此文件中的标签.

<configuration> <property> <name>dfs.replication</name> <value>1</value> </property> <property> <name>dfs.name.dir</name> <value>file:///home/hadoop/hadoopinfra/hdfs/namenode</value> </property> <property> <name>dfs.data.dir</name> <value>file:///home/hadoop/hadoopinfra/hdfs/datanode</value> </property> </configuration>

注意 : 在上面的文件中,所有属性值都是用户定义的,您可以根据您的Hadoop基础结构进行更改.

此文件用于将纱线配置为Hadoop.打开yarn-site.xml文件,并在< configuration>,</configuration>之间添加以下属性.此文件中的标签.

<configuration> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> </configuration>

此文件用于指定我们使用的MapReduce框架.默认情况下,Hadoop包含yarn-site.xml的模板.首先,您需要使用以下命令将文件从 mapred-site,xml.template 复制到 mapred-site.xml 文件.

$ cp mapred-site.xml.template mapred-site.xml

打开mapred- site.xml文件并在< configuration>,</configuration>之间添加以下属性此文件中的标签.

<configuration> <property> <name>mapreduce.framework.name</name> <value>yarn</value> </property> </configuration>

以下步骤用于验证Hadoop安装.

使用命令"hdfs namenode -format"设置namenode,如下所示 :

$ cd ~ $ hdfs namenode -format

预期结果如下 :

10/24/14 21:30:55 INFO namenode.NameNode:STARTUP_MSG: /*********** ************************************************* STARTUP_MSG:开始NameNode STARTUP_MSG:host = localhost/192.168.1.11 STARTUP_MSG:args = [-format] STARTUP_MSG:version = 2.4.1 ... ... 10/24/14 21:30:56 INFO common.Storage:存储目录 /home/hadoop/hadoopinfra/hdfs/namenode已成功格式化. 10/24/14 21:30:56 INFO namenode.NNStorageRetentionManager:使用txid> = 0保留1 图像10/24/14 21:30:56 INFO util.ExitUtil:退出状态为0 10/24/14 21:30:56 INFO namenode.NameNode:SHUTDOWN_MSG: /********************* *************************************** SHUTDOWN_MSG:关闭localhost的NameNode/192.168.1.11 ****************************************** ******************/

以下命令用于启动DFS.执行此命令将启动您的Hadoop文件系统.

$ start-dfs.sh

预期输出如下 :

10/24/14 21:30:55 INFO namenode.NameNode: STARTUP_MSG: /************************************************************ STARTUP_MSG: Starting NameNode STARTUP_MSG: host = localhost/192.168.1.11 STARTUP_MSG: args = [-format] STARTUP_MSG: version = 2.4.1 ... ... 10/24/14 21:30:56 INFO common.Storage: Storage directory /home/hadoop/hadoopinfra/hdfs/namenode has been successfully formatted. 10/24/14 21:30:56 INFO namenode.NNStorageRetentionManager: Going to retain 1 images with txid >= 0 10/24/14 21:30:56 INFO util.ExitUtil: Exiting with status 0 10/24/14 21:30:56 INFO namenode.NameNode: SHUTDOWN_MSG: /************************************************************ SHUTDOWN_MSG: Shutting down NameNode at localhost/192.168.1.11 ************************************************************/

以下命令用于启动纱线脚本.执行此命令将启动您的Yarn守护进程.

$ start-yarn.sh

预期输出如下 :

10/24/14 21:37:56 Starting namenodes on [localhost] localhost: starting namenode, logging to /home/hadoop/hadoop-2.4.1/logs/hadoop-hadoop-namenode-localhost.out localhost: starting datanode, logging to /home/hadoop/hadoop-2.4.1/logs/hadoop-hadoop-datanode-localhost.out Starting secondary namenodes [0.0.0.0]

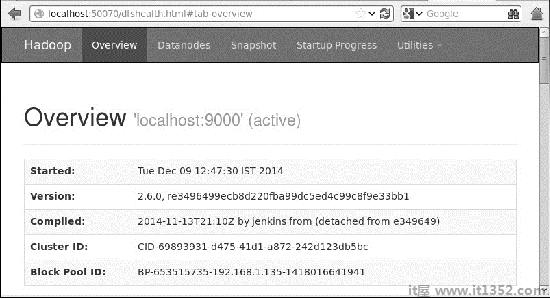

访问Hadoop的默认端口号是50070使用以下URL在您的浏览器上获取Hadoop服务.

http://localhost:50070/

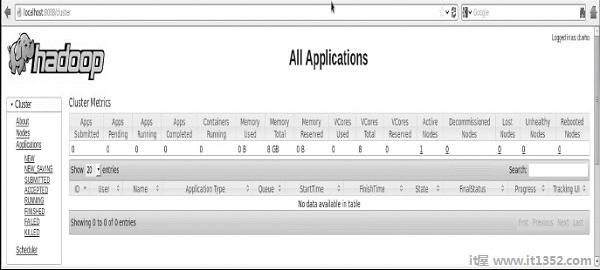

验证群集的所有应用程序

访问群集的所有应用程序的默认端口号是8088.以下网址访问此服务.

http://localhost:8088/

完成后安装Hadoop,继续下一步,在你的系统上安装Hive.

我们使用hive-0.14.0在本教程中.您可以访问以下链接 http://apache.petsads.us/hive/hive-0.14.0/下载它.我们假设它被下载到/Downloads 目录中.在这里,我们为本教程下载名为" apache-hive-0.14.0-bin.tar.gz "的Hive存档.以下命令用于验证下载和减号;

$ cd Downloads $ ls

成功下载后,您会看到以下回复 :

apache-hive-0.14.0 -bin.tar.gz

在您的Hive上安装Hive需要执行以下步骤系统.我们假设Hive存档已下载到/Downloads 目录.

以下命令用于验证下载并提取Hive存档 :

$ tar zxvf apache-hive-0.14.0-bin.tar. gz $ ls

成功下载后,您会看到以下回复 :

apache-hive-0.14.0-bin apache-hive-0.14.0-bin.tar.gz

我们需要从超级用户"su - "复制文件.以下命令用于将文件从解压缩的目录复制到/usr/local/hive "目录.

$ su - passwd: # cd /home/user/Download # mv apache-hive-0.14.0-bin /usr/local/hive # exit

您可以通过在

export HIVE_HOME=/usr/local/hive export PATH=$PATH:$HIVE_HOME/bin export CLASSPATH=$CLASSPATH:/usr/local/Hadoop/lib/*:. export CLASSPATH=$CLASSPATH:/usr/local/hive/lib/*:.

以下命令用于执行〜/.bashrc文件.

$ source~/.bashrc

要使用Hadoop配置Hive,您需要编辑 hive-env.sh 文件,该文件位于 $ HIVE_HOME/conf 目录中.以下命令重定向到Hive config 文件夹并复制模板文件 :

$ cd $ HIVE_HOME/conf $ cp hive-env.sh.template hive-env.sh

编辑 hive-env.sh 文件通过附加以下行 :

export HADOOP_HOME =/usr/local/hadoop

有了这个,Hive安装就完成了.现在,您需要外部数据库服务器来配置Metastore.我们使用Apache Derby数据库.

按照下面给出的步骤下载并安装Apache Derby :

以下命令用于下载Apache Derby.下载需要一些时间.

$ cd~ $ wget http://archive.apache.org/dist/db/derby/db-derby-10.4.2.0/db-derby-10.4.2.0-bin.tar.gz

以下命令用于验证下载 :

$ ls

成功下载后,你会得到看到以下回复 :

db-derby-10.4.2.0-bin.tar.gz

以下命令用于提取和验证Derby存档 :

$ tar zxvf db-derby-10.4.2.0-bin.tar.gz $ ls

成功下载后,您将看到以下响应 :

db-derby-10.4.2.0-bin db-derby-10.4.2.0 -bin.tar.gz

我们需要从超级用户"su - "复制.以下命令用于将文件从解压缩的目录复制到/usr/local/derby 目录 :

$ su - passwd: # cd /home/user # mv db-derby-10.4.2.0-bin /usr/local/derby # exit

您可以通过将以下行添加到〜来设置Derby环境/.bashrc file :

export DERBY_HOME=/usr/local/derby export PATH=$PATH:$DERBY_HOME/bin export CLASSPATH=$CLASSPATH:$DERBY_HOME/lib/derby.jar:$DERBY_HOME/lib/derbytools.jar

以下命令用于执行〜/.bashrc文件 :

$ source~/.bashrc

在$ DERBY_HOME目录中创建名为 data 的目录以存储Metastore数据.

$ mkdir $ DERBY_HOME/data

Derby安装和环境设置现已完成.

配置Metastore意味着指定Hive存储数据库的位置.您可以通过编辑 $ HIVE_HOME/conf 目录中的 hive-site.xml 文件来完成此操作.首先,使用以下命令复制模板文件 :

$ cd $ HIVE_HOME/conf $ cp hive-default .xml.template hive-site.xml

编辑 hive-site.xml 并在< configuration>之间追加以下行;和</configuration>标签 :

<property> <name>javax.jdo.option.ConnectionURL</name> <value>jdbc:derby://localhost:1527/metastore_db;create = true</value> <description>JDBC connect string for a JDBC metastore</description> </property>

创建一个名为 jpox.properties 的文件,并在其中添加以下行 :

javax.jdo.PersistenceManagerFactoryClass = org.jpox.PersistenceManagerFactoryImpl org.jpox.autoCreateSchema = false org.jpox.validateTables = false org.jpox.validateColumns = false org.jpox.validateConstraints = false org.jpox.storeManagerType = rdbms org.jpox.autoCreateSchema = true org.jpox.autoStartMechanismMode = checked org.jpox.transactionIsolation = read_committed javax.jdo.option.DetachAllOnCommit = true javax.jdo.option.NontransactionalRead = true javax.jdo.option.ConnectionDriverName = org.apache.derby.jdbc.ClientDriver javax.jdo.option.ConnectionURL = jdbc:derby://hadoop1:1527/metastore_db;create = true javax.jdo.option.ConnectionUserName = APP javax.jdo.option.ConnectionPassword = mine

在运行Hive之前,您需要在HDFS中创建/tmp 文件夹和单独的Hive文件夹.在这里,我们使用/user/hive/warehouse 文件夹.您需要为这些新创建的文件夹设置写入权限,如下所示 :

chmod g+w

现在在验证Hive之前将它们设置为HDFS.使用以下命令 :

$ $HADOOP_HOME/bin/hadoop fs -mkdir /tmp $ $HADOOP_HOME/bin/hadoop fs -mkdir /user/hive/warehouse $ $HADOOP_HOME/bin/hadoop fs -chmod g+w /tmp $ $HADOOP_HOME/bin/hadoop fs -chmod g+w /user/hive/warehouse

以下命令用于验证Hive安装 :

$ cd $HIVE_HOME $ bin/hive

成功安装Hive后,您会看到以下响应 :

Logging initialized using configuration in jar:file:/home/hadoop/hive-0.9.0/lib/hive-common-0.9.0.jar!/ hive-log4j.properties Hive history =/tmp/hadoop/hive_job_log_hadoop_201312121621_1494929084.txt …………………. hive>

您可以执行以下示例命令来显示所有表 :

hive> show tables; OK Time taken: 2.798 seconds hive>

使用以下命令设置系统变量 HCAT_HOME for HCatalog Home.

export HCAT_HOME = $HiVE_HOME/HCatalog

使用以下命令验证HCatalog的安装.

cd $HCAT_HOME/bin ./hcat

如果安装成功,您将看到以下输出 :

SLF4J: Actual binding is of type [org.slf4j.impl.Log4jLoggerFactory]

usage: hcat { -e "<query>" | -f "<filepath>" }

[ -g "<group>" ] [ -p "<perms>" ]

[ -D"<name> = <value>" ]

-D <property = value> use hadoop value for given property

-e <exec> hcat command given from command line

-f <file> hcat commands in file

-g <group> group for the db/table specified in CREATE statement

-h,--help Print help information

-p <perms> permissions for the db/table specified in CREATE statement中指定的db/table的权限